萧箫 发自 凹非寺量子位 | 公众号 QbitAI

图灵奖得主Bengio和Hinton,同时警告AI可能灭绝人类!

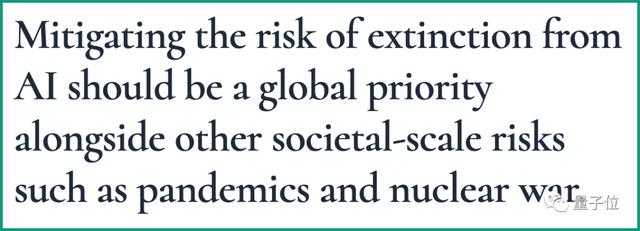

就在昨夜,一封签署名单多达350人的公开信迅速传播开去,信中核心只有一句话:

“降低AI灭绝人类的风险”,应该像流行病和核战争等其它社会规模的风险一样,成为全球的优先事项。

也包括不少国内外高校的教授,除了Yoshua Bengio和Geoffrey Hinton以外,清华AIR院长张亚勤和斯坦福教授、图灵奖得主Martin Hellman等人也名列其中。

这段时间来,关于AI风险的各种大小讨论也是接连不断,OpenAI CEO Sam Altman前段时间还倡议称,人们应当像对待核设施一样监管AI。

所以,究竟是谁发起的这封公开信倡议,又是否有AI大牛反对这件事?

为何签署这封信?发布这封公开信的机构名叫Center for AI Safety(CAIS),是一家关于AI安全的非营利组织。

在这封公开信的开头,CAIS反复强调:

包括AI专家、记者、政策制定者和公众在内,越来越多的人开始讨论AI带来的一系列重要和紧迫的风险。

即便如此,要想表达对先进AI的严重风险,可能还是有一定难度。这封公开信旨在克服这一障碍,并展开对相关议题的讨论,让更多专家和公众人物认识到这一点。

对此,纽约大学教授Gary Marcus补充道:

不要把框架缩小到只关注人类灭绝的风险。AI其实还存在许多其他的严重风险,包括可能帮助开发生物武器等。

不过,Gary Marcus同样没有签署这份350人公开信。

显然包括不少AI大牛在内,反对者主要有两种意见。

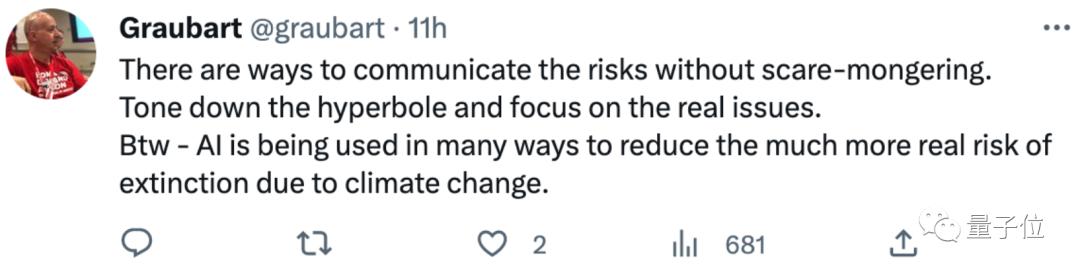

一种意见认为,AI技术确实存在风险,但这封公开信涉及到的内容太泛泛。

如果有更精确的声明如“减轻AI技术的潜在风险应该是科技行业、政府和该领域学术研究人员的首要任务”,那么这封信还是可以签署的。

这封公开信中的内容根本就是夸大其词了,而且AI在气候变化等领域甚至可以起到降低风险的作用。

另一类意见则认为,这封信只不过是当前掌握最领先AI技术的人,试图控制AI接下来的走向而已。

以OpenAI的CEO Sam Altman为例:

Sam Altman要是真的担心,大可以现在直接关掉ChatGPT服务器。

所以,你认为按照现在的进度来看,AI有可能灭绝人类吗?

参考链接:[1]https://www.safe.ai/statement-on-ai-risk[2]https://www.nytimes.com/2023/05/30/technology/ai-threat-warning.html?smtyp=cur&smid=tw-nytimes[3]https://twitter.com/AndrewYNg/status/1663584330751561735[4]https://www.reddit.com/r/MachineLearning/comments/13vls63/n_hinton_bengio_and_other_ai_experts_sign/

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

花粉社群VIP加油站

猜你喜欢