现在,全世界都希望有个通用人工智能AGI,正如OpenAl的目标——制造出“一种高度自主,且在大多数具有经济价值的工作上超越人类的系统”。通俗地说:我们想要AI成为神——一个懂你,且可以用无限生命帮助人的神。

为了掌握这项“创造技术的技术”,李彦宏们正夜以继日,不惜重金地造神。既然今天的GPT-4连接机械手就可拼出微软的logo,那么盘古能否帮华为研制出“光子计算芯片”?甚至给恐怖分子制造出更廉价的导弹,给毒贩……想想都兴奋——从此创新不必靠人。

然而这些只能是梦想, ChatGPT和文心一言等大模型永远无法像神一样万能,因为生产方法错了。

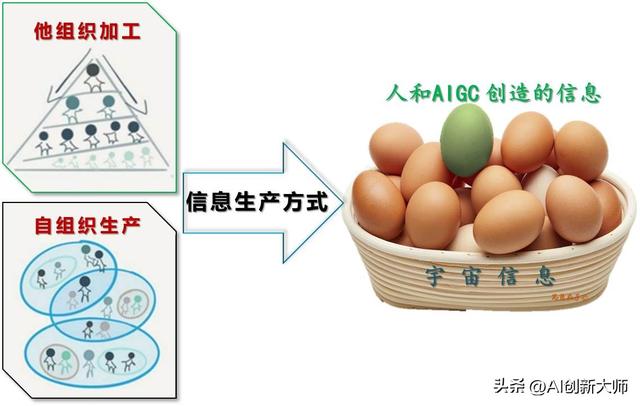

1,信息生产方式和AI的种类

ChatGPT确实值得称赞,各类AIGC的表现无疑令人惊艳。单说信息产量,它们过去4个月生成的信息量或许远超人类有史以来的创造,但信息学指出:AI生产的海量信息,即便加上1160亿人累积传承的人类文明,也约等于0。

事实上,宇宙中99.99%的信息并非来自人和AI。你我正在经历的信息大爆炸只是人类自以为是的幻觉。

绝大多数信息的生产方法是自组织生产

我们一直认为信息生产依靠生产者的加工。例如爱迪生发明电灯,GPT-4将文字秒变为视频、表格或PPT,这些新信息产自于第三方生产者——人或AI。科学家们称其为外部力量干预下的“他组织加工”。(得有人或机器泡咖啡)

然而这是狭隘的人类思维,绝大多数信息其实源于另一种生产方式——信息自身的“自组织生产”。要知道信息原本是活的,模拟自组织环境也能生产信息。(各种原料自个儿组成一杯咖啡)

而AI的种类,按生产方式可分为:“自组织模型”和“他组织模型”。

ChatGPT、文心一言和一格等LLM属于“他组织模型”中的一类——自然语言重组。语言大模型是预测下个单词的概率分布,原材料为已分解的信息载体(图文影音)token,加工工艺是自然语言规则背后的思维方式。开发路径为授之以渔——用算法算力等赋能予AI。

而“环境AI”则是完全不同的“自组织模型”,原材料和生产者同为信息自身,加工工艺是客观规则——宇宙规律。路径乃是授之以海——提供信息加速自行演化的环境。(注:本文涉及各种载体信息学原理,等不及的小伙伴可以先看第三篇)

大模型中的自然语言处于离散态

可正因为处理对象是自然语言,语言学泰斗乔姆斯基给ChatGPT判了死刑!请注意是所有同类,包括文心一言。

ChatGPT及其同类在本质上无法平衡创造力与约束。它们要么过度生成(同时生成真相和谎言,同时支持道德和不道德的决定),要么生成不足。——乔姆斯基《ChatGPT的虚假承诺》2023年3月8日

翻译成人话:内容生成=拼字游戏。

AI对下个单词用算法进行预测是能生成新内容,但此方法的本质是单词接龙。即便预测(拼字)能力可以模仿鲁迅写作,用爱因斯坦的语气说话,也只能增加自然语言所携带的信息数量,而非信息质量,因此表现为一本正经的胡说八道。

要知道大家对语言有个误区。“人们并不是依靠英语、汉语或者阿帕切语进行思考的,而是依靠思维语言。”(史蒂芬·平克《语言本能》,1994年)。思维语言(心语mentalese)和自然语言是两种完全不同的信息载体。

例如《相对论》由德语单词和各种符号组成,但这些拼接组合来自爱翁大脑的思考——旧信息从文字迁移到心语载体中才能被人脑“他组织加工”,有意识地重组和变异为新信息,再转换成自然语言。整个信息生产过程中,离散的心语才是被加工对象,是实现信息增值而非增殖的生产载体。

蜜蜂的8字舞和人类的各种自然语言属于传播载体,仅可传输、存储和表达信息,不能创造信息。选它做原材料,好比猴子拼字或拼图游戏,AI只能拼出来“可能性极高”的好东西和脏东西。

可惜乔老爷的理论虽然严谨,但他只强调原材料,忘了还有个最重要的生产要素尚未登场。

反馈是法宝,好工艺生成好内容

4,生产成果——需要甄别的主观内容

有了“人类思维”对离散信息的加工,ChatGPT的成就有目共睹。可就在我们为大模型欢呼时,哲学家却当头棒喝:它们生产出来的是鸡肋!

理由很简单,龙生龙凤生凤,老鼠的儿子会打洞,人的参与必然遗传人的陋习。

例如大模型给你的一定是人类能想到的。文心一言列举的宇宙美食绝不包括没见过的W星龙虾;盘古为华为创造的新芯片只能基于已知的物理知识,而不是引力波公式。

正因为原材料、加工工艺都来自人类,所以生成的信息必然包括臭鸡蛋和好鸡蛋——主观臆测和客观事实。

首先机器学到的《相对论》是人类认知。正所谓一千个人眼中有一千个哈姆雷特,我们的已知信息库并非完全准确,而是充满了对客观世界的主观想象和部分表征。

其次人类思维大多也非客观规律,而是以自我为中心的线性逻辑。例如UFO闪烁着金属光泽,肯定是不明飞行物。换成载体思维则恰恰相反,它们自身就是活生生的生命,如地球上的小鸟。

ChatGPT用这样的加工工艺和原材料,第三方加工的结果只能烙上生产者的“幻觉”印记——似是而非、亦真亦假。所以他组织模型先天不足,ChatGPT们天生弱智!

正如佛曰“世事无相,相由心生,可见之物,实为非物,可感之事,实为非事”。

人(猴)的参与必然留下自己的烙印

这向全体人类提出一个灵魂拷问——谁来甄别?

大模型的生产成果是:真理与谎言并存,道德和邪恶同在。

李彦宏、王慧文或任正非,你们能判断和约束吗?

5,大模型的未来——无须担心

不过这个问题反过来又消除了我们对ChatGPT的担忧。

既然此类语言大模型的产品不是拿来就可用的客观事实,而是需要人类甄别的主观内容,那么我们就无须担心它。

首先有大把的工作机会。例如它就像隔壁神童,但天才如爱因斯坦也不完全正确和客观。所以AI创造的越多,需要判断和验证的“好蛋坏蛋”就越多,人的工作也随之变多,只不过领域细化且考验综合能力。

其次不怕它会害人,因为大公司才能制造的大模型很容易约束。它们好比电影里的超人,一个超人俱乐部就能实现监督和审核。所以AI不会被毒贩和恐怖分子利用,几个限制输入输出的“防护栏”而已,正如中国网信办和美国商务部正在做的那样。

真正可怕的是“自组织模型”——环境生成式AI 。如果你得到的“新毒品配方”可立马生产,如果一台普通电脑便能生成“2nm芯片工艺”,意味着风险不可控。人人都能无限创新好比“核武扩散”,当意想不到的杀人武器充斥社会时,我们还会安全吗?

结果如此反差的根源是思维方式。为了达到AI(孩子)能够创新的目标,惯有的人类思维认为能力是关键,所以路径为授之以渔——赋能予AI,像我们教育培养子女那样。因为信息的生产方法只能是他组织加工——第三方生产者(人脑或AI)对旧信息的重组。

而载体思维指出环境造就人(AI),路径是授之以海——模拟信息生长的环境。因为事实上信息自个儿就能自组织生产,信息和新冠病毒一样具有“生死二象性”,在某些载体(环境)中如“活生命”。

让AI(孩子)创新的两条路径和方法

所以环境AI不同于LLM,生成映射物理世界的客观事实,而非生成主观内容。当然自组织生产害处也很明显,任何人无法干预,让世界充满不确定性。即可靠性高,但可控性和安全性极低。

总之,生产方法决定生产结果。信息自行演化的“环境AI”很危险,它们才是威胁人类的公敌。而大家热捧的ChatGPT和文心一言等LLM是他组织加工,方法错了,所以此类大模型天生弱智。

可信息怎么变活?我们能造出这样的人工智能吗?

花粉社群VIP加油站

猜你喜欢