大型语言模型(LLM)的出现,让人类看到了真正迈入智能时代的曙光。人们一方面感叹它的能力,一方面又担忧它是否会真的产生“自主意识”甚至毁灭人类。

以OpenAI的ChatGPT为代表的大型语言模型(LLM)就像一个黑匣子,即使是数据科学家也很难知道为什么它总能以自己的方式作出反应,就像在凭空捏造事实一样。

为了搞清楚LLM到底是怎么运行的,OpenAI正在开发一种工具来自动识别LLM的哪些部分对其行为负责。为此,工程师团队选择用GPT-4来解释更简单的模型GPT-2的行为逻辑。

只有知道AI模型给出答案的逻辑才能更好地理解它的行为,从而提高性能并减少危害性。OpenAI的可解释性团队经理WilliamSaunders说:“我们正在尝试预测人工智能系统会出现什么问题。我们希望真正能够知道我们可以相信模型在做什么以及它产生的答案。”

用GPT-4解释GPT-2就像人的大脑一样,LLM也是由神经元组成的,这些神经元通过观察文本中的某些特定模式来影响整个模型接下来“说”的内容。假如模型中有一个“漫威超级英雄神经元”,那就会提升它在回答中提及漫威英雄的概率。

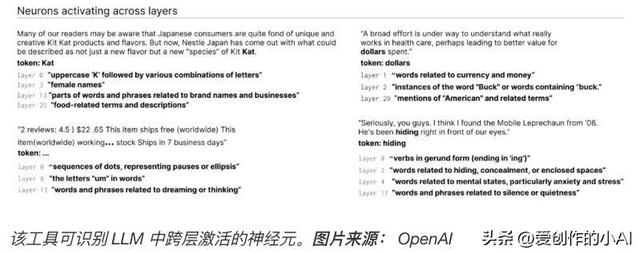

OpenAI将模型分解为各个部分,通过让模型运行不同文本序列,并观察特定神经元被频繁“激活”情况的方式观察它的行为逻辑。开发团队将这些高度活跃的神经元以及相关的文本情况展示给GPT-4,并让它生成解释。为了确定解释的准确性,开发人员还让GPT-4预测或模拟神经元的行为方式,然后将模拟神经元的行为与实际神经元的行为进行比较。

“使用这种方法,我们基本上可以为每个神经元提出某种初步的自然语言解释来说明它在做什么,并且还可以对这种解释与实际行为的匹配程度进行评分。”OpenAI的可扩展对齐团队负责人JeffWu说:“我们使用GPT-4作为过程的一部分来解释神经元正在寻找什么,然后对这些解释与它正在做的事情的实际情况相匹配的程度进行评分。”

研究人员已经对GPT-2中所有的307200个神经元生成解释,并将这些解释与工具代码一起发布到了GitHub上。

研究人员表示,类似这样的工具有朝一日可用于改善LLM的性能ーー例如减少偏差或有害内容的生成。但他们承认,此类工具要想真正实用还有很长的路要走。目前研究人员对这个工具中的大约1000个神经元的解释很有信心,但只占总数的一小部分。

有人认为OpenAI解释LLM行为的研究只是为了给GPT-4做广告,因为这些研究都是基于GPT-4才能做的。但JeffWu解释说并非如此,他认为研究中使用GPT-4只是“偶然”,相反,这些研究显示了GPT-4在这方面的弱点。

目前,该工具的大多数解释得分很低,或者不能解释实际神经元的大部分行为。JeffWu说:“例如,许多神经元在某种程度上是活跃的,很难判断发生了什么,就像它们在五六个不同的事物上活跃,但没有可辨别的模式。有时候有一个明显的模式,但GPT-4无法找到它。”

更不用说更复杂、更新、更大的模型,或者可以浏览网页获取信息的模型了。但关于第二点,JeffWu认为网页浏览不会对工具的底层机制产生太大影响。只要简单地对其进行调整就可以弄清楚为什么神经元决定进行某些搜索引擎查询或访问特定网站。

“我们希望这将开辟一条有希望的途径,以自动化的方式解决可解释性问题,其他人可以在此基础上做出贡献。”JeffWu说:“我们的希望是,我们真的能够很好地解释不仅仅是神经元对什么做出反应,而是整体上解释这些模型的行为ーー它们在计算什么样的路线,以及某些神经元如何影响其他神经元。”

花粉社群VIP加油站

猜你喜欢