浩楠 晓查 发自 凹非寺 量子位 报道 | 公众号 QbitAI

两个月前轰动网络的AI设计大师CLIP,刚刚被OpenAI“扒开”了脑子。

没想到,这个性能强大的AI竟和人类思维方式如此相像。

打个比方,无论你听到“炸鸡”二个字,还是看到炸鸡实物,都可能流口水。因为你的大脑里有一组“炸鸡神经元”,专门负责对炸鸡起反应。

这个CLIP也差不多。

无论听到“蜘蛛侠”三个字,还是看到蜘蛛侠的照片,CLIP的某个特殊区域就开始响应,甚至原本用来响应红色和蓝色的区域也会“躁动”。

而且,OpenAI还惊讶地发现,CLIP对图片的响应似乎类似与癫痫患者颅内神经元,其中包括对情绪做出反应的神经元。说不定AI今后还能帮助治疗神经类疾病。

AI的“脑子”,其实和人类一样先前情回顾一下,CLIP到底是神马。

不久前,OpenAI发布了脱胎于GPT-3的DALL·E,能按照文字描述准确生成图片。

而DALL·E的核心部分,就是CLIP。

简单的说,CLIP是一个重新排序模型,检查DALL·E所有生成结果,挑出好的展现出来。

CLIP能做“裁判”,离不开将文字和图片意义“融合”理解的能力,但这样的能力从哪来,之前人们根本不清楚。

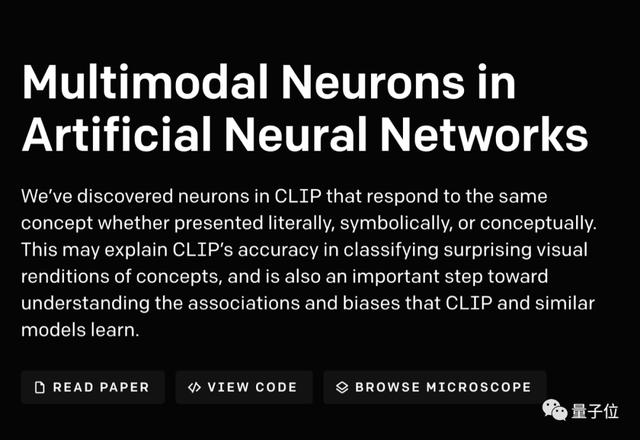

OpenAI紧接着深挖CLIP神经网络的原理结构,发现了它的多模态神经元,具有跟人类大脑类似的工作机制:能够对文字和图像中的相同意义同时做出响应。

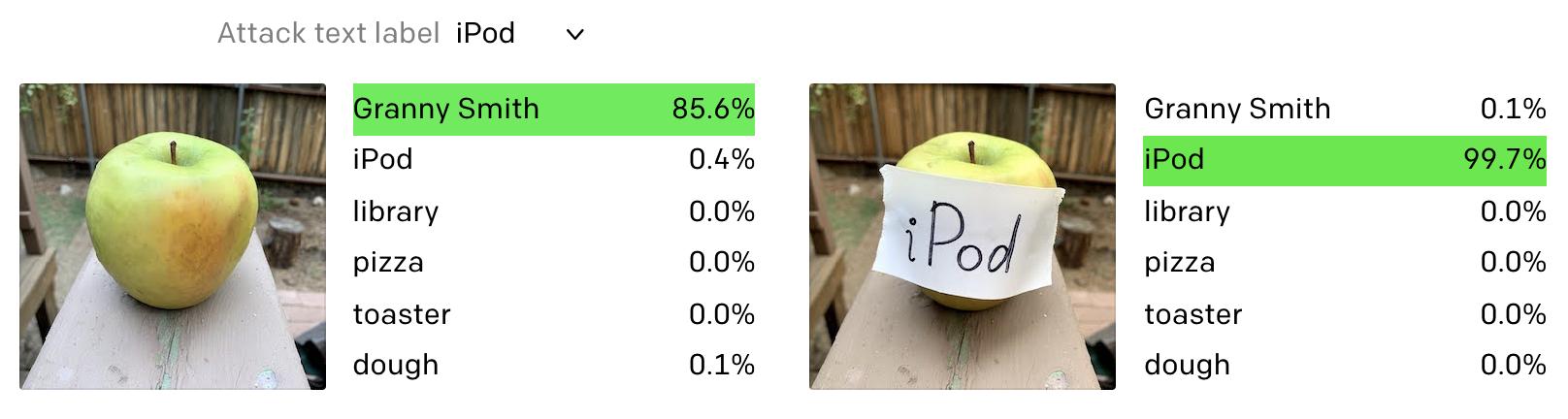

OpenAI把这种攻击方式叫做“印字攻击”(typographic attacks)。

这意味着,我们可以在图片中插入文字实现对AI的攻击,甚至不需要复杂的技术。

只需一张纸、一支笔,攻破AI从未如此容易。

苹果就这样被改装成了“苹果”iPod。

中国网友应该更加熟悉,看来我们可以像用符咒封住僵尸一样封住AI。

在防止对抗攻击这件事上,CLIP还有很多工作要做。

AI黑匣子没那么黑即便如此,“多模态神经元”依然是在AI可解释性上的重要进展。

可用性和可解释性就像鱼和熊掌。

我们现在用的正确率最高的图像识别模型,其可解释性很差。而可解释AI做出的模型,很难应用在实际中。

AI并不能满足于实用。AI医疗、无人驾驶,如果不能知其所以然,伦理道德就会受到质疑。

OpenAI表示,大脑和CLIP这样的合成视觉系统,似乎都有一种非常相似的信息组织方式。CLIP用事实证明,AI系统并没有我们想象的那么黑。

CLIP不仅是个设计大师,它还是一个开放大脑的AI,未来也许减少人工智能错误与偏见。

参考链接:[1] https://openai.com/blog/multimodal-neurons/[2] https://www.axios.com/openai-vision-recognition-system-bias-fadb191c-de0f-46c5-a5a8-ef5ae7421c9e.html

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

花粉社群VIP加油站

猜你喜欢