杨净 发自 凹非寺量子位 报道 | 公众号 QbitAI

今天,谷歌大脑声称,他们新技术能训练万亿级参数的语言模型。

万亿级,什么概念?

烧了微软10000张显卡的GPT-3,也不过1750亿参数。

现在,他们将这参数量扩大到9倍——16000亿参数。

这一语言模型正是Switch Transformer,自称是迄今为止最大的模型,其预训练速度是谷歌以前开发的最大语言模型(T5-XXL)的4倍。

Switch Transformer的创新之处在于,它有效利用了一些硬件,比如GPU和谷歌的TPU等为稠密矩阵乘法设计的硬件。

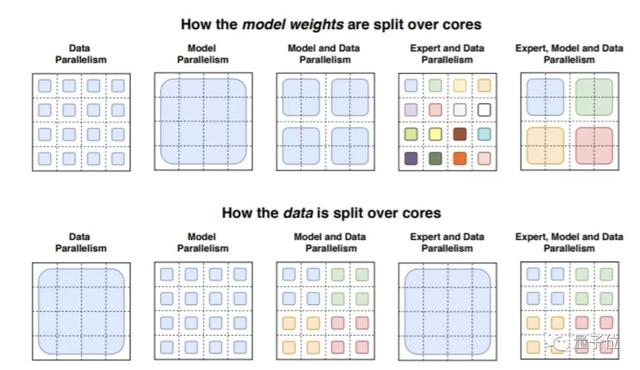

在分布式训练设置中,模型的稀疏激活层在不同设备上分配唯一的权重。所以,模型权重随设备数量的增加而增加,同时在每个设备上保持可管理的内存和计算空间。

接着,研究人员使用了32个TPU内核在一个数据集上预训练了几个不同的Switch Transformer模型。

这一数据集叫做Colossal Clean Crawled Corpus,750GB大小,包含了从Reddit、维基百科和其他网络资源中搜索的文本。

研究人员给这些模型布置了任务,比如,在有15%单词被掩盖的段落中预测出缺失的单词;检索文本来回答问题。

研究人员表示,他们拥有2048个专家系统的1.6万亿参数模型(Switch-C)“完全没有不稳定性”,其速度相比于T5-XXL模型提升了4倍。

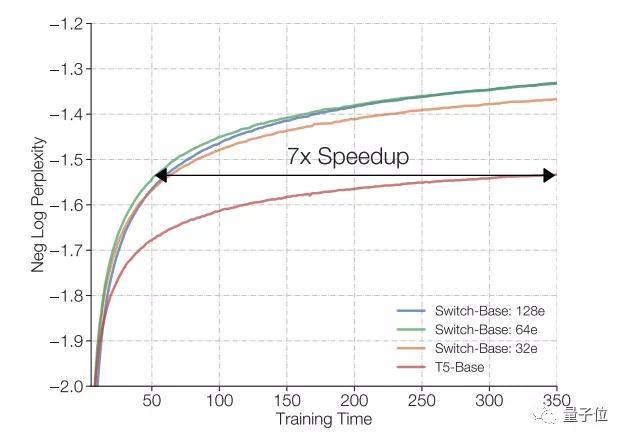

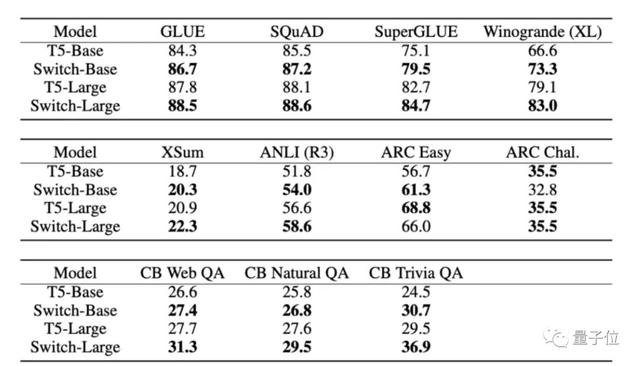

此外,研究者还将模型与T5-Base和 T5-Large进行了对比,结果表明,在相同的计算资源下,新模型预训练速度有最高7倍的提升。

研究人员表示,大型稀疏模型可用于创建较小的密集模型,在任务上进行微调,其质量增益为大型模型的30%。

从整体结果上看,Switch Transformer 模型在多项推理和知识任务中带来了显著性能提升。这说明该模型架构不只对预训练有用,还可以通过微调将质量改进迁移至下游任务中。

研究人员表示,

我们无法完全保留模型质量,但通过将我们的稀疏模型提炼成密集模型,可以实现10到100倍的压缩率,同时实现约30%的专家模型的质量增益。

在未来的工作中,研究人员计划将Switch Transformer应用于不同模态或多模态模型,包括图像和文本。

参考链接:论文地址:https://arxiv.org/abs/2101.03961https://venturebeat.com/2021/01/12/google-trained-a-trillion-parameter-ai-language-model/

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态

花粉社群VIP加油站

猜你喜欢