接下来作者们对下游的各种NLP任务进行了实验,想要了解更多细节的朋友可以去arXiv上查看原始论文。

https://arxiv.org/pdf/2005.14165.pdf

OpenAI这次不光拼参数量,还要拼作者数量?这次的GPT-3论文作者足足有31位,现在语言模型不仅要拼参数量,还要拼作者数量吗?

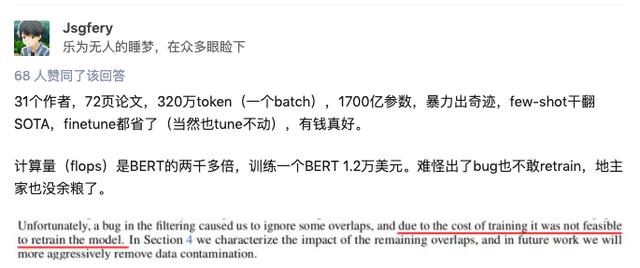

计算量是BERT的2000多倍,知乎网友Jsgfery表示,这么大的模型跑一次就好,可千万别出bug,地主家也没有余粮再训练一次了。

GPT2生成的虚假文章已经让人真假难辨,至少在语句的通顺性上是这样。GPT-3的效果将更胜GPT2,有网友也表示我们将会败给GPT-3,如果以后网页的内容都是自动生成的,那阅读还有什么意义?

OpenAI 去年发布了 GPT-2,因为担心该模型可能被恶意使用,并没有放出预训练的模型。有些网友评论说应该改名Closeai,但是OpenAI这种审慎的做法也有不少人赞同。网友们也关心 GPT-3的完整版本是否会开源,或者是否会有7个规模从1.25亿到130亿不等的小版本时,OpenAI没有给予明确答复。

参考链接:

https://www.zhihu.com/question/398114261

https://arxiv.org/abs/2005.14165

花粉社群VIP加油站

猜你喜欢