机器之心报道

机器之心编辑部

ChatGPT 这次成为数百个模型的管理者。

几个月来,ChatGPT、GPT-4 的相继爆火,让人们看到大型语言模型 (LLM) 在语言理解、生成、交互和推理方面表现出的非凡能力,这引起了学界和业界的极大关注,也让人们看到了 LLM 在构建通用人工智能 (AGI) 系统方面的潜力。

要实现 AGI,LLM 要面临诸多挑战,包括:

受限于文本生成的输入和输出形式,当前的 LLM 缺乏处理视觉和语音等复杂信息的能力;在现实场景中,一些复杂的任务通常由多个子任务组成,因此需要多个模型的调度和协作,这也超出了语言模型的能力范围;对于一些具有挑战性的任务,LLM 在零样本或少样本情况下表现出优异的结果,但它们仍然弱于一些专用的微调模型。其中,最重要的一点是实现 AGI 需要解决不同领域、不同模式的复杂 AI 任务,而现有 AI 模型大多是用于特定领域特定任务。

基于此,来自浙江大学和微软亚研的研究者最近提出了一种让 LLM 充当控制器的新方法,让 LLM 来管理现有的 AI 模型以解决复杂的 AI 任务,并且使用语言作为通用接口。该研究提出的 HuggingGPT 是一个利用 LLM 连接机器学习社区(例如 HuggingFace)中各种 AI 模型以解决复杂 AI 任务的系统。

接下来我们看看这四步具体实现过程。

任务规划

在 HuggingGPT 的第一阶段,大型语言模型接受用户请求并将其分解为一系列结构化任务。复杂的请求往往涉及多个任务,大型语言模型需要确定这些任务的依赖关系和执行顺序。为了促使大型语言模型进行有效的任务规划,HuggingGPT 在其提示设计中采用了基于规范的指令和基于演示的解析。

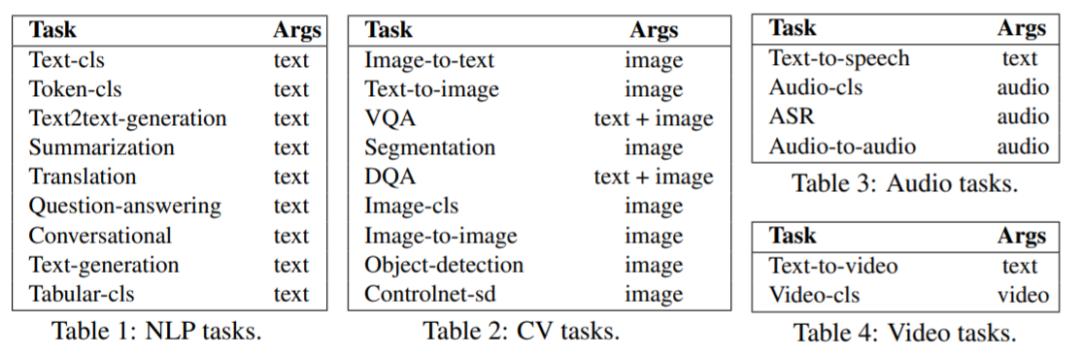

通过在提示中注入几个演示,HuggingGPT 允许大型语言模型更好地理解任务规划意图和标准。目前,HuggingGPT 支持的任务列表如表 1、表 2、表 3 和表 4 所示。可以看出,HuggingGPT 覆盖 NLP、CV、语音、视频等任务。

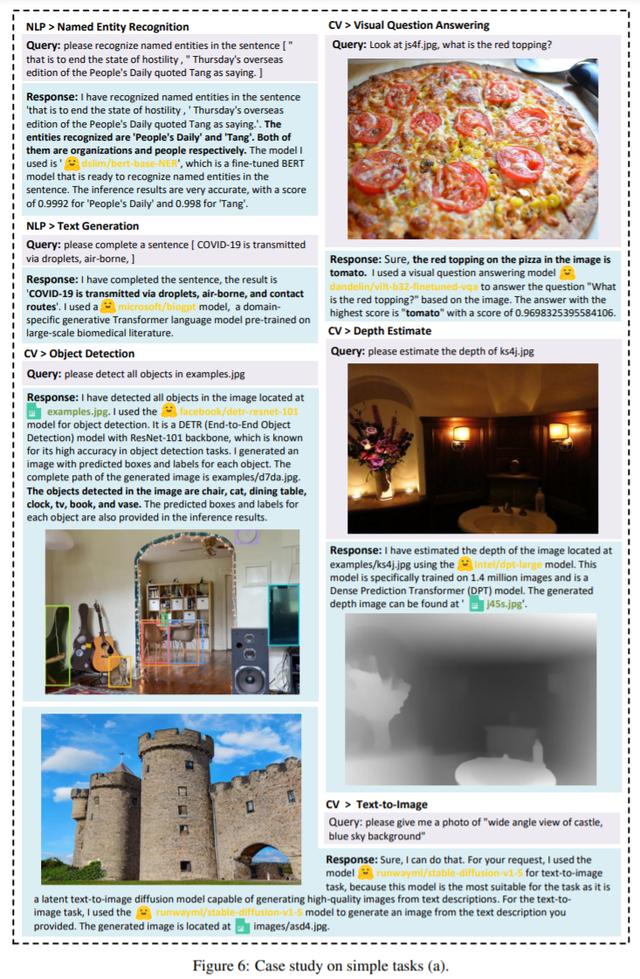

该研究还在多模态任务上测试了 HuggingGPT,如下图所示。在大型语言模型和专家模型的配合下,HuggingGPT 可以解决语言、图像、音频、视频等多种模态,包含了检测、生成、分类和问答等多种形式的任务。

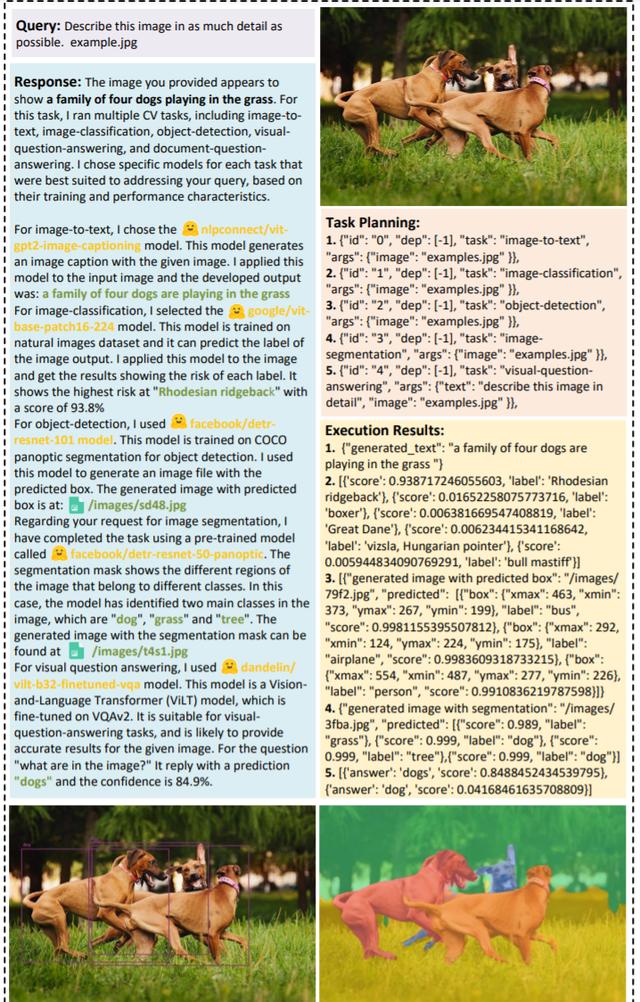

图 9 显示,对于一个简单的尽可能详细地描述图像的请求,HuggingGPT 可以将其扩展为五个相关任务,即图像字幕、图像分类、物体检测、分割和视觉问答。HuggingGPT 为每个任务分配专家模型,这些模型从 LLM 的不同方面提供与图像相关的信息。最后,LLM 将这些信息进行整合,并做出全面而详细的描述。

还有人将其比喻为公司经理,评论道「HuggingGPT 有点像现实世界中的场景,公司有一群超强的工程师,在各个专业能力超群,现在有一个经理把他们管理起来,当有人有需求,那么这个经理就会分析需求,然后分给相应的工程师去做,最后合并在一起再返回给用户。」

参考链接:https://twitter.com/search?q=HuggingGPT&src=typed_query&f=top

花粉社群VIP加油站

猜你喜欢